AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

当前的视觉语言模型(VLM)主要通过 QA 问答形式进行性能评测,而缺乏对模型基础理解能力的评测,例如 detail image caption 性能的可靠评测手段。

针对这一问题,中科院、北大和字节大模型团队发布了 DetailCaps-4870 数据集,并提出了一种有效的评估指标 CAPTURE,取得了开源评估指标中最高的专家评价一致性,并低成本实现了与 GPT-Eval 可比的效果。

简介

当前的 LVLM(large vision-language model)评测存在以下问题:

针对这些问题,该研究提出了新的 Detail image caption benchmark 和 evaluation metric,以在较低的成本下实现了对 LVLM 图像理解能力的准确评估。

在所提出的评测数据集 & 指标的指导下,该研究还探索了发掘 LVLM 自身能力进行 detail image caption 的数据构造方法,有效提升了 detail caption 数据质量。

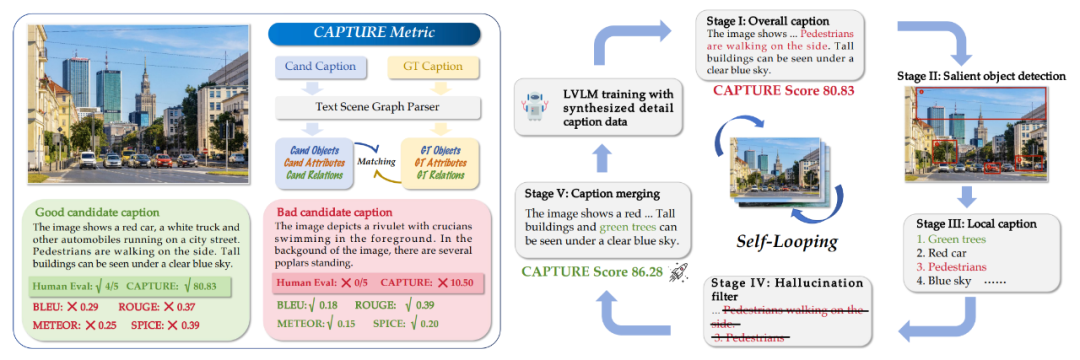

图一:左侧为 CAPTURE metric 实例展示,右侧为 detail caption construction 方法展示

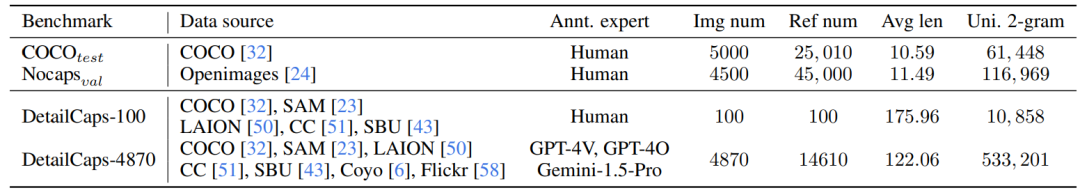

数据集

相比类似大小的评测数据集,该研究提出的 Detail image caption benchmark 文本长度更长,无重复的 2-gram 数量明显更多,包含更丰富的视觉信息:

表一:DetailCaps benchmark 统计信息

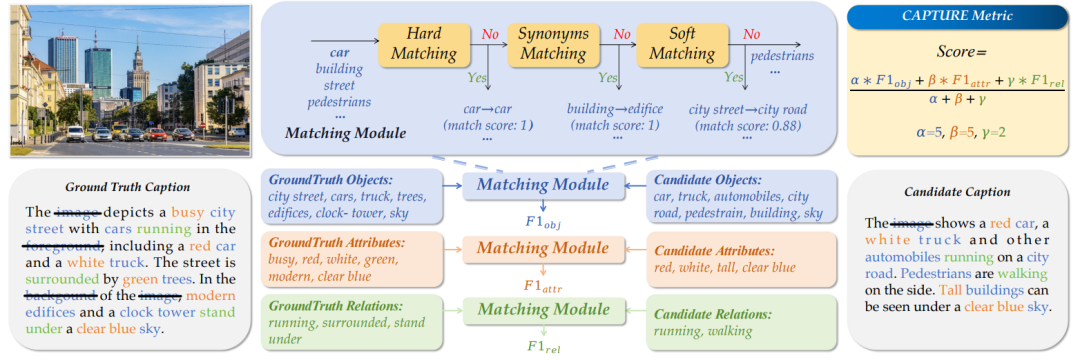

评估指标

该研究所提出的 CAPTURE (CAPtion evaluation by exTracting and coUpling coRE information) 指标通过 4 步进行 caption 质量评估。如下图所示,首先使用 Factual praser 抽取 detail caption 中的 object, attribute, relation 元素,紧接着过滤掉没有实际意义的 objects。之后,通过三阶段匹配(精确匹配、近义词匹配、embedding 匹配)分别计算 obj、attr、rel 元素的匹配得分(F1 分数),加权作为最终结果。

图二:CAPTURE metric 详细计算步骤

Detail caption 数据合成

在 DetailCaps benchmark 和 CAPTURE metric 的指导下,该研究提出了一种基于 divide-and-conquer 思想发掘 LVLM 潜力进行数据合成的方法,有效提升了 detail caption 数据质量。该方案首先使用 LVLM 进行全图 caption 生成,之后使用分割模型(SAM )和聚类等过滤方法找到图中的关键位置并将其裁剪出来进行局部 caption 生成。文章使用一种 word-level 的过滤方法来减少 caption 中的幻觉,该方法首先解析(parse)出描述图中视觉元素的词和短语,再通过目标检测模型(Owlv2 )过滤掉得分低的元素。最后,将过滤后的全图 caption、局部 caption 送入 LLM(LLaMA2 )融合为最终的图像描述。

实验

CAPTURE 指标

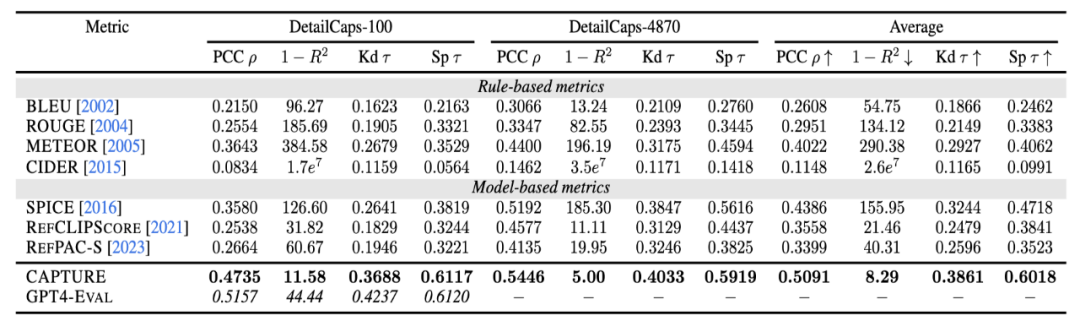

(1)CAPTURE vs 其他 caption 指标

该研究在 DetailCaps-100(人工标注 reference caption,人工评估模型生成 caption 得分)和 DetailCaps-4870(GPT 标注 reference caption,GPT-4 评估模型生成 caption 得分)上,对 LLaVA-1.5 、CogVLM 和 ShareCaptioner 三个模型生成的 caption 进行了专家打分,并计算各个评估指标与专家评价的一致性:

表二:CAPTURE 与其他 detail image caption 评估指标的专家评价一致性对比

各 caption 评估指标和专家评价的一致性通过 pearson correlation(线性相关性)、 R^2(绝对值大小)、 Kendall's tau(排序偏序对一致性)和 (Per-) Sample (Kendall's) tau(每个样本单独计算取平均)指标进行衡量。

结果显示,CAPTURE 在各种指标上都取得了最优的专家评价一致性。在这些指标中,Sample tau 与实际 detail image caption 评估的计算方式最为接近,CAPTURE 也是唯一在这个指标上取得与 GPT4-Eval 接近的方法,在评估的准确率、成本上取得了良好的平衡。

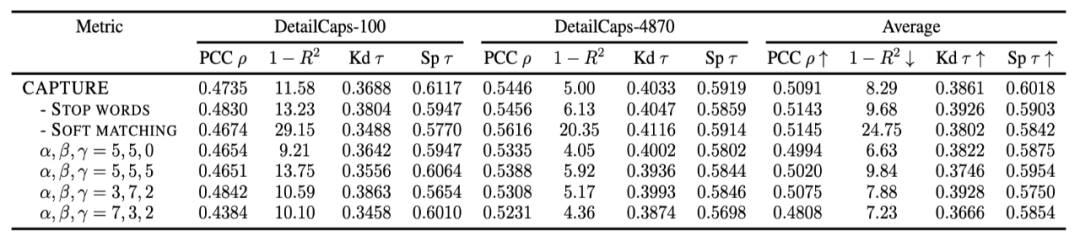

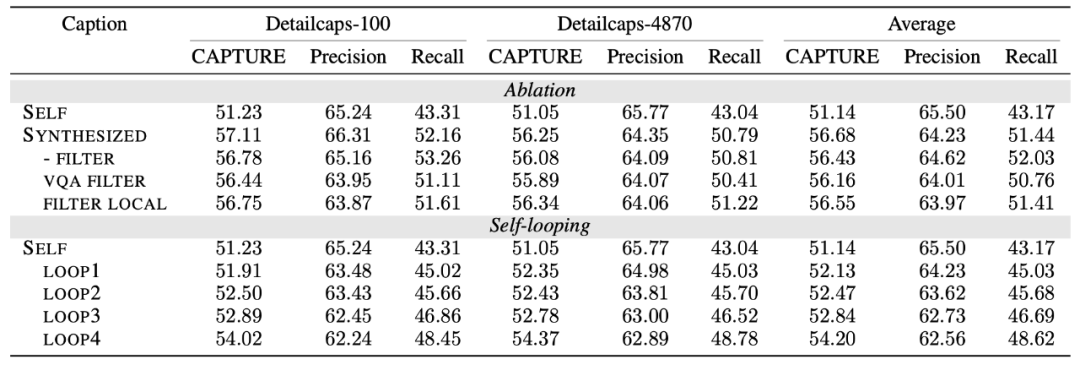

(2)消融分析

研究者还对 CAPTURE 中的各个模块进行了消融分析,并验证其有效性:

表三:CAPTURE 各模块的消融分析

实验结果显示,Stop words 有效提升了 Sample tau,说明了该模块的有效性。但是 stop words filtering 会对不同样例的 detail caption 造成不同的影响,从而导致 pcc、kendall tau 微降。Soft matching 也提升了 sample tau,同时在 1-R2 分数上有明显增益作用,将 CAPTURE 预测分数和专家打分的绝对分值对齐。在加权计算最终得分时,obj:attr:rel 比例取 default 的 5:5:2 最好,提升或降低各元素的比重都会造成性能下降。

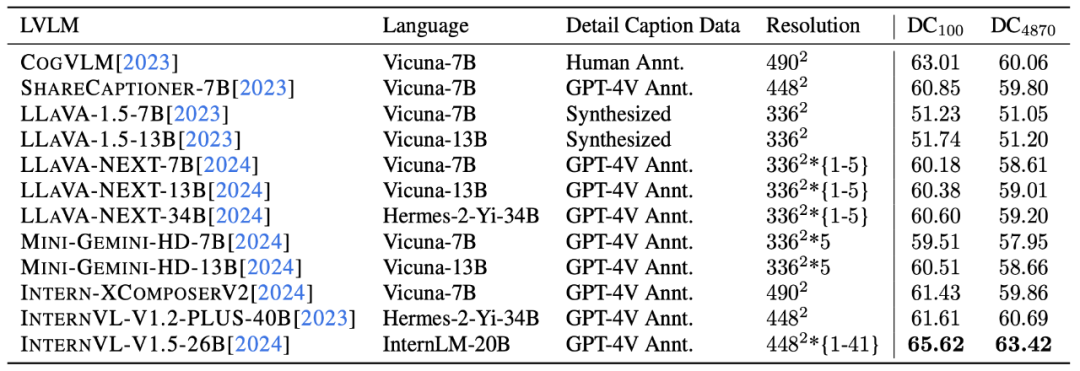

(3)开源 LVLM 的 detail caption 性能

表四:开源 LVLM 的 detail caption 性能对比

总体来看,InternVL-1.5 是当前表现最好的开源 LVLM。从 LLaVA、MiniGemini 结果可以看出,LLM 参数量的提升对模型 detail caption 能力有一致的提升作用。同时,分辨率较高、使用高质量 detail caption 进行训练的模型,性能会更好。

Detail caption 数据构造

基于 detail caption 评估数据集和评测指标,研究者验证了所提出的 detail caption 数据合成方案的有效性。

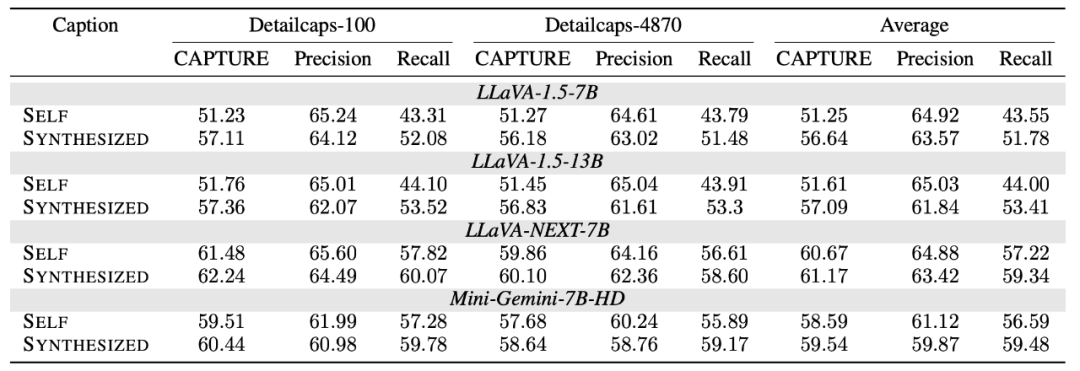

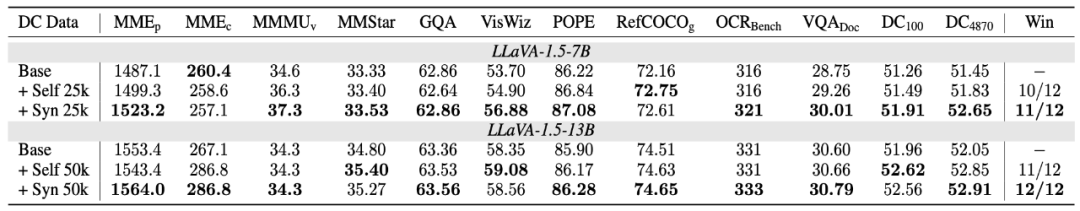

(1)Detail caption 合成方法在不同 LVLM 上的有效性

如下表所示,该研究提出的 detail caption 合成方法在 LLaVA-1.5-7B、LLaVA-1.5-13B、LLaVA-NEXT-7B 和 Mini-Gemini-7B-HD 上取得了一致的 detail caption 质量提升:

表五:不同 LVLM 使用该研究提出的 detail caption 合成方法效果

(2)通过 Self-loop 进一步提升 detail caption 性能

研究者还尝试通过数据打标 -> 模型训练 -> 重新打标的训练流程进行 Self-loop 来进一步提升 LVLM detail caption 性能,在四轮 loop 中都取得了正面效果。同时,对比开源方案 与本文所提出的 word-level 幻觉过滤方案,证明了其设计的有效性:

表六:Detail caption 合成方案的 self-looping 效果和消融分析

(3)LVLM 自身打标的 detail caption 可提升其整体性能

该研究使用 LLaVA-1.5 按照给出的 detail caption 构造方案对 sharegpt4v-100k 数据进行了重新打标,并将打标数据用于 LLaVA-1.5 的 SFT 训练,在多个 benchmark 上取得了一致的性能提升:

表七:合成 detail caption 数据在 LLaVA-1.5-7B 模型训练中的作用